Несколько лет назад мы с мужем, кибернетиком Майклом Андерсоном, запрограммировали робота для ухода за пациентами в больнице. Он должен был напоминать им о приеме лекарств, а если курс лечения не соблюдался, докладывать врачу. Тонкость была в том, что робот выполнял не только техническую функцию. Он еще и принимал самостоятельные решения, руковод ствуясь собственными представлениями о благополучии пациента. Ему приходилось учитывать пользу, которую получает пациент, принимая лекарства, и вред, который может принести нежелание вовремя их принимать (об этом роботу сообщал лечащий врач). Кроме того, робот должен был также уважать независимость и свободу пациента. Если, скажем, болезнь была не слишком опасная, а пациент забывал выпить таблетку, засмотревшись любимой телепередачей, лишнее напоминание со стороны робота могло принести ему больше неудовольствия (то есть вреда), чем пользы. Если же пропуск лекарства грозил серьезными последствиями, приходилось напоминать о приеме в любом случае, а на худой конец — жаловаться врачу. В зависимости от того, какова иерархия ценностей, встроенная в робота, он может принимать в сходных случаях разные решения.

Чувство алгоритма

Когда роботы вроде этого станут обыденностью, у них могут появиться и более сложные иерархии ценностей. В частности, они должны будут думать и о собственной способности выполнять свои прямые обязанности — например вовремя заряжать батареи. Кроме того, у робота, особенно если он присматривает за несколькими людьми сразу, может быть чувство справедливости: в таком случае он будет, например, переключать каналы в телевизоре, учитывая не только конфликтующие желания пациентов, но и то, какие желания были исполнены в прошлый раз.

Это лишь первые шаги на пути к машине, способной решать по-настоящему сложные жизненные задачи, но с чего-то надо начинать, если хочешь построить нравст венного робота. А в этом и состоит цель дисциплины под названием машинная этика.

Есть два способа построить робота, руководствующегося этическими принципами. Первый — просто запрограммировать машину вести себя этично или хотя бы избегать дурных поступков. Такой робот совершает правильные действия, но не умеет явным образом объяснять их смысл. Он ограничен в своем поведении замыслом создателя, который в данном случае и является настоящим нравственным агентом, ответственным лицом. Но есть и второй способ. Он предполагает создание машины, имеющей собст венное представление о законах нравственности и способной дейст вовать автономно, оперируя этим знанием. Философ Джеймс Мур называл роботов первого и второго рода имплицитным и эксплицитным нравственными агентами. Именно последнего пытаются создать люди, занимающиеся машинной этикой. Почему эта область знаний важна? Тому есть по меньшей мере три причины.

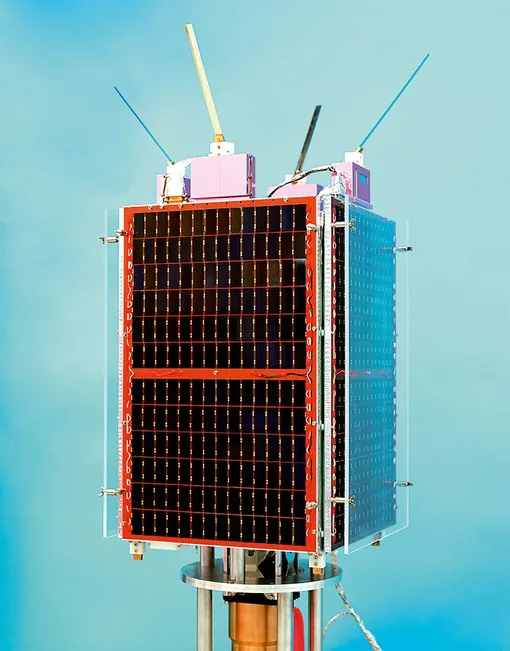

Во-первых, существуют моральные проблемы, непосредственно связанные с тем, что роботы уже делают сейчас и будут делать в будущем. Игнорировать этот аспект поведения машин было бы легкомыслием. В Южной Корее, например, есть правительственная программа, цель которой — снабдить бытовым роботом каждый дом. Автоматические машины без водителей уже ездят по трассам, а скоро заполонят улицы городов. Военные роботы способны поддерживать огнем наземные операции и несут противотанковые орудия, в небе летают беспилотные истребители (которые, к счастью, пока не принимают самостоятельных решений). Путь от семейных авто, управляемых без помощи водителя, и умной бытовой техники до автономных созданий, меняющих наше представление о границах интеллекта и способных нанести реальный вред людям, нельзя пройти, не обезопасив себя каким-то этическим компонентом, встроенным в роботов.

Во-вторых, человеческий страх перед автономными мыслящими машинами, как мне кажется, во многом связан с неуверенностью, что они будут вести себя должным образом. Научная фантастика полна таких страхов. Значит, создание этических ограничителей для роботов может заставить общество лучше воспринимать исследования в области искусственного интеллекта. Надо отдавать себе отчет, что общество не сможет удержать всех изобретателей от разработки разумных автономных машин, даже если захочет запретить это. В случае успеха подобных исследований очень важно иметь этические принципы, которые, по настоянию общества, должны быть встроены в эти машины. Если чего-то стоит бояться больше, чем разумных автономных роботов, так это автономных роботов, лишенных представлений о нравственности.

В-третьих, изучение машинной этики продвинет изучение этики вообще. Несмотря на то что эта область философии хороша постольку, поскольку применима на практике, теоретические работы часто оперируют нереалистичными жизненными ситуациями. Примеры, которые привыкли обсуждать философы, как правило, выдуманы. Взять хотя бы классическую дилемму: можно ли сбросить под поезд одного человека, если это спасет жизни пяти? А десяти? А пятнадцати, среди которых есть два младенца? А двадцать неизлечимо больных? Приложение искусственного разума к проблемам этики поможет лучше понять проблемы сущест вующих теорий, и даже открыть путь для новых. Как говорил философ Дэниел Деннет, искусственный интеллект «делает философию честной». Чтобы научить машины разрешать этические дилеммы, мы должны сперва сделать этику последовательной и исчислимой.

Наконец — и об этом мало кто задумывается, — робот и в самом деле может принимать лучшие этические решения, чем человек. Ведь люди не строго следуют арифметике счастья. Они, как правило, просто прикидывают результат на глаз, а для робота такое поведение было бы странным. В отличие от роботов, люди пристрастны и склонны предпочитать и ценить своих близких больше, чем всех остальных. При этом люди никогда не станут рассматривать все возможные в некой ситуации действия, и тут роботы могут выиграть у них просто за счет аккуратности. А для некоторых человеческих поступков, например совершенных президентом США или генеральным директором крупной корпорации, послед ствия столь разнообразны и многочисленны, что человек физически не может их просчитать. Роботу, благодаря все возрастающей мощности современных компьютеров, это дастся куда проще.

Главная надежда изысканий в области машинной нравственности состоит в том, что этику можно сделать исчислимой, то есть понятной компьютеру. Уже есть программы, позволяющие машинам подсказывать человеку правильное решение. Хочется верить, что это первый шаг на пути создания роботов, которые смогут принимать такие решения сами. Обществу будет гораздо легче принять думающие машины, если поначалу они не будут сами по себе моральными агентами, а ограничатся советами.

Есть и еще одна причина для такого положения вещей. Этика как дисциплина пока не развита настолько, чтобы даже эксперты могли сойтись на том, каков правильный ответ в каждой этической дилемме. Например, ту же проблему с поездом разные теории решают по-разному: утилитаристы считают, что жертвовать жизнью одного для спасения многих можно, деонтологи — что нельзя, поскольку цель не может оправдывать средства. Но консенсуса не существует и по более жизненным вопросам вроде того, допустимы ли аборты, и если да, то при каких обстоятельствах. Советник может учитывать это — и перекладывать сложные решения на плечи человека. Автономная же машина в таком случае либо потеряет способность действовать самостоятельно, либо будет принимать случайное решение. Ни то, ни другое нас не устраивает.

Конечно, есть действия, которые не только эксперты, но и все мы признаем неправильными (например рабство или измыватель ство над детьми). Но философы научились мириться и с тем, что у нас нет готовых ответов на все вопросы, и даже с тем, что какие-то из принятых сегодня этических норм будут в будущем пересмотрены. В любом случае тем, кто работает над нравст венными роботами, лучше бы исходить из идеи, что есть серые этические зоны, и в некоторых ситуациях мы еще не можем сказать, какое поведение правильно.

В конце концов, нам придется решать, какая теория и какой подход верны. Я придерживаюсь того мнения, что простой теории, сформулированной в качестве единственного, абсолютного долга, недостаточно. Этика на деле сложнее — и по этой причине любой из этих теорий можно легко придумать контрпример. Гораздо продуктивнее иерархическая система, включающая множество ценностей, из которых одни подчинены другим. Вроде той, какой пользовался больничный робот, только гораздо сложнее.

Иерархическим образом устроено самое известное руководство по поведению роботов, «три закона роботехники», сформулированные Айзеком Азимовым в 1942 году. Законы эти выглядят так:

1. Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

2. Робот должен повиноваться всем приказам человека, кроме тех случаев, когда эти приказы противоречат Первому закону.

3. Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому и Второму законам.

По-моему, эти три закона, даже если не вдаваться в формулировки, не могут применяться к нравственному роботу. Более того, сам Азимов довольно убедительно показал, что это так — в рассказе «Двухсотлетний человек», написанном к

Главный герой рассказа, от лица которого ведется повествование, — робот Эндрю. На протяжении рассказа он постепенно борется за свою свободу, признание себя человеком, и в конце концов получает ее в суде. Эндрю — исключительный робот. Азимов сначала демон стрирует, как тот может заниматься творческой деятельностью (резать по дереву) и получать от этого удовольствие. Его хозяйка даже добивается для него разрешения получать деньги за свою работу. Затем мы видим, что подчиненное положение робота приносит ему страдания: в одном эпизоде Эндрю, носившего к тому времени человеческую одежду, ловят хулиганы и заставляют раздеваться, пользуясь вторым законом роботехники. Чтобы получить права человека, Эндрю даже идет на своего рода самоубийство — перепрограммирует свой позитронный мозг, чтобы тот умер через сто лет. Робот-хирург, который совершает операцию, сначала отказывается это делать: он не может причинять вреда. Но Эндрю поправляет его: робот не может наносить вреда человеку, а я робот.

Рассказ Азимова — на самом деле метафора эмансипации негров в США. Но так или иначе, Азимову удалось показать, насколько робот, способный вести себя нравственно, достоин свободы, и насколько его нравственное чувство превосходит поведение окружающих его людей, которые слишком легко поддаются эмоциям. Если у Эндрю и был сбой этических принципов, то он касался как раз его собственной судьбы: робот не признавал своего права быть свободным, прежде чем получил его по суду.

Пока мы можем не задумываться об этом, но если когда-нибудь нравственные роботы появятся, нам придется размышлять на эту тему. Можно ли требовать беспрекословного подчинения от существ, которые ведут себя лучше, чем мы, и осознают это? Как сказал судья, даровавший свободу Эндрю, «у нас нет права отказывать в свободе любому, кто обладает достаточно развитым сознанием, чтобы понимать смысл этой идеи и желать этого состояния».

Фотограф Питер Фрейзер / © Peter Fraser, courtesy Brancolini Grimaldi